Una possibile definizione di informatica è la seguente:

«scienza della rappresentazione e dell'elaborazione (e archiviazione e trasmissione a distanza) delle informazioni».

Da questa definizione, e da altre simili, emerge l'importanza del concetto di informazione e delle modalità con cui essa viene rappresentata, per poi essere elaborata, nel sistema di elaborazione.

Questi due termini vengono spesso usati come sinonimi (anche nel seguito di queste dispense) ma tra essi esiste una sottile differenze che deve comunque essere chiarita:

una informazione è qualcosa che permette di accrescere la conoscenza su un qualche fatto, oggetto o più in generale su una qualche entità anche astratta;

un dato è la parte costitutiva di una informazione ma da solo non permette di accrescere la conoscenza di alcunché.

Si può anche dire che una informazione è costituita da un dato (o da più dati) accompagnato dal suo significato.

Una ulteriore osservazione che permette di differenziare i due oggetti è la seguente:

una informazione viene memorizzata nella memoria umana, un dato viene memorizzato nelle memorie artificiali del sistema di elaborazione.

L'informazione richiede un supporto fisico per essere rappresentata, trasmessa, archiviata; essa però non coincide con il supporto, non è un'entità fisica ma logica e si può creare e distruggere (contrariamente al supporto fisico che è soggetto al ben noto principio di conservazione della materia-energia).

Il supporto fisico deve poter assumere configurazioni diverse per essere in grado di rappresentare informazioni; se infatti se la configurazione fosse sempre la stessa, non avremmo alcuna informazione dalla sua osservazione.

In termini più formali possiamo dire che: tanto minore è la probabilità che si presenti una configurazione, tanto maggiore è l'informazione che essa porta (quindi una configurazione certa, cioè con probabilità 1, non porta alcuna informazione).

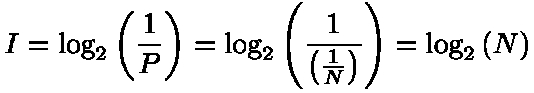

Il concetto può essere espresso anche con una formula che permette di ottenere la misura dell'informazione veicolata da un supporto o da un messaggio che prevede N configurazioni equiprobabili con probabilità P = 1/N (Shannon 1948):

|

|

La formula conferma che se la probabilità della configurazione è 1 la quantità di informazione è nulla.

Nel caso del sistema di elaborazione le informazioni sono memorizzate su supporti in grado di assumere due configurazioni con probabilità 1/2 ciascuna; in questo caso quindi l'unità di misura dell'informazione è:

|

|

Questa unità di misura prende il nome di bit, parola derivata da binary digit, cioè cifra binaria, (che può valere 0 oppure 1).

Se consideriamo il sistema di numerazione decimale possiamo calcolare la quantità di informazione di ogni cifra (che ha probabilità 1/10):

|

|

e concludere quindi che per rappresentare una cifra decimale occorre un numero di bit pari a 4 (intero superiore a 3.32).

Se consideriamo invece un numero composto da 3 cifre decimali vediamo che occorrono 10 bit (3.32 + 3.32 + 3.32).

Questi aspetti, relativi all'uso delle cifre binarie per rappresentare i valori decimali, vengono approfonditi nel prossimo capitolo.